L’évolution des services liés à l’IA commence à remodeler la demande de réseaux à fibre optique à haut débit, à grande capacité et à faible latence. Voici l’état des lieux tel que nous le voyons.

Pour beaucoup de gens, l’IA est encore une nouveauté. Il suffit de voir l’engouement récent pour les mèmes suscité par le générateur d’images de style Studio Ghibli d’OpenAI pour comprendre qu’en termes de marché de masse, l’IA générative n’en est qu’à ses balbutiements.

Mais en coulisses, l’IA évolue et mûrit, à la fois dans ses cas d’utilisation et dans les services qui les soutiennent. De nombreux cas d’utilisation impliquent de grandes quantités de données ou une réactivité en temps réel, ce qui commence à avoir un impact profond sur la demande de vitesse, de bande passante et de latence du réseau.

Dans ce blog, nous examinons quatre services émergents liés à l’IA et la façon dont une connectivité résiliente sous-tend le succès dans un monde régi par des systèmes distribués basés sur l’informatique en nuage.

Quatre nouveaux services d’IA et leurs implications en matière de connectivité

L’évolution des cas d’utilisation de l’IA à forte intensité de données stimule l’introduction de nouveaux services par les opérateurs historiques et les startups. Dans le cadre de nos travaux avec des entreprises du secteur de l’IA, nous constatons l’émergence de quatre nouveaux types de services.

1. Formation de modèles en temps réel

Aujourd’hui, les grands modèles linguistiques (LLM) tels que GPT-4, Llama et Claude ont été pré-entraînés avant d’être déployés auprès des développeurs et des utilisateurs – en fait, GPT signifie generative pre-trained transformer (transformateur génératif pré-entraîné). La collecte de données d’entraînement pour ces modèles n’est pas une question de temps et l’entraînement est effectué hors ligne.

Aujourd’hui, certains services adoptent une approche en temps réel, où les données sont collectées en permanence et utilisées pour former le modèle à la volée. La formation en temps réel peut trouver des applications dans des secteurs où les informations utilisées pour la prise de décision changent rapidement, comme la défense, la santé publique ou la banque.

L’impact sur les besoins en bande passante est potentiellement colossal, en fonction du volume et de la nature des données collectées, ainsi que de l’emplacement des données et du modèle en cours de formation. Une approche stratégique de la connectivité et des partenaires de connectivité fiables et flexibles seront essentiels.

2. Grappes d’inférence

Les clusters d’inférence représentent les déploiements d’un LLM pré-entraîné particulier pour une utilisation spécifique. Un exemple pourrait être le chatbot du service clientèle d’un détaillant qui utilise GPT4 comme modèle. L’inférence est le travail effectué par le LLM pré-entraîné pour générer des réponses pertinentes à la requête d’un client.

L’utilisation croissante des LLM rend coûteux, du point de vue du transport des données, le fait d’effectuer tout le travail d’inférence au même endroit physique que le modèle – par exemple, si le modèle est hébergé aux États-Unis mais que les utilisateurs se trouvent en Europe.

On s’attend également à ce que le moteur d’inférence réponde en temps réel aux utilisateurs. Selon le secteur, les régulateurs peuvent également exiger que les données des utilisateurs restent en Europe, ce qui exclut l’utilisation d’un modèle hébergé aux États-Unis.

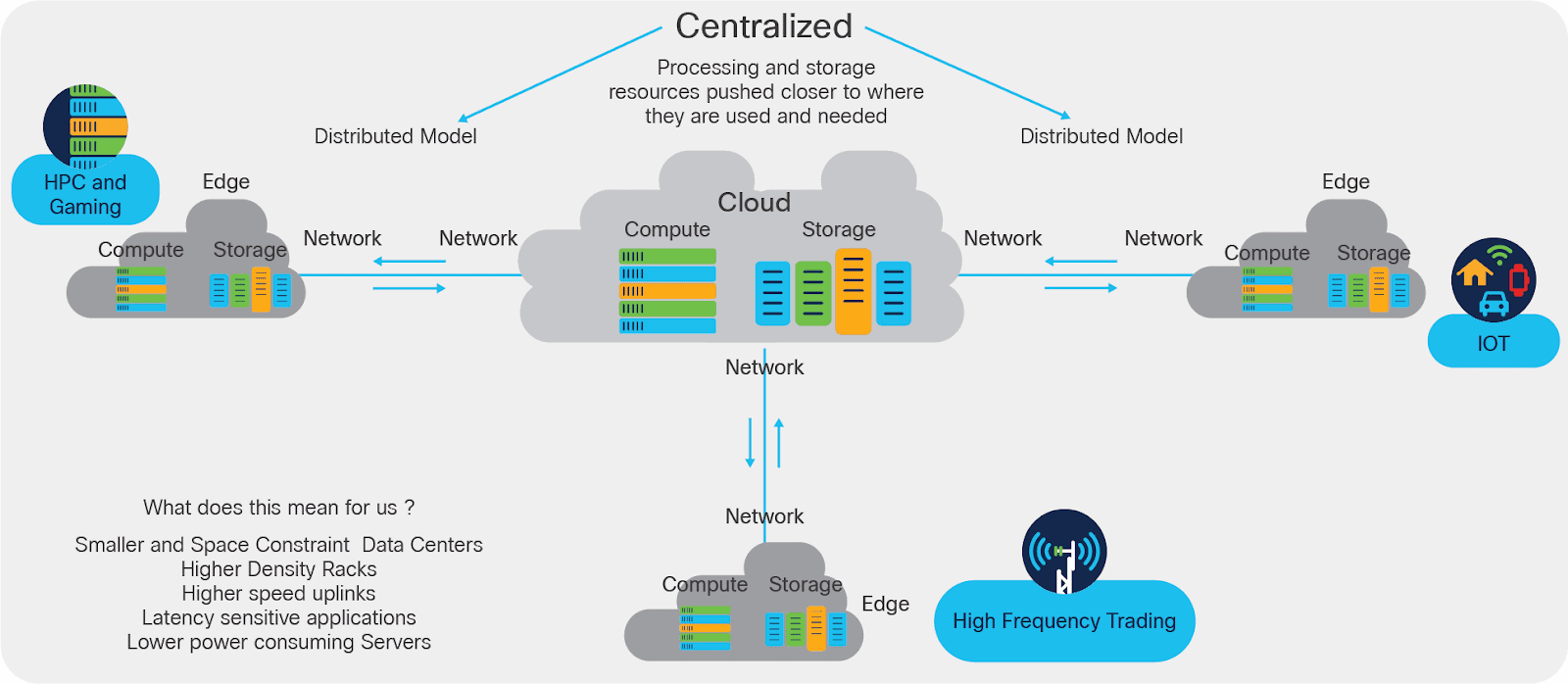

Une solution consiste à créer des grappes d’inférence : des déploiements localisés du modèle qui conservent les données de l’utilisateur au niveau local, exigent que les données soient transportées sur des distances plus courtes et répondent plus rapidement en raison d’une latence plus faible.

Les entreprises qui déploient des grappes d’inférence géographiquement réparties ont besoin d’une connectivité à large bande passante et à faible latence vers, depuis et entre chaque grappe, afin de maintenir les modèles synchronisés et à jour, de gérer une base d’utilisateurs croissante et de faire face à des pics d’utilisation imprévisibles.

3. Néoclouds

La demande croissante de clusters d’inférence et d’autres déploiements LLM distribués entraîne l’émergence d’un nouveau type de fournisseur d’infrastructure. Étant donné que les LLM nécessitent des GPU puissants pour fonctionner, nous assistons à la montée en puissance des sociétés “neocloud” dédiées à l’offre de ressources GPU en tant que service (GPUaaS).

Fonctionnant sur un modèle de consommation similaire à celui des hyperscalers, les néoclouds sont conçus pour gérer des charges de travail d’IA spécifiques – de l’entraînement de modèles à l’inférence et à l’analyse prédictive. Digital Ocean, par exemple, propose des GPU bare-metal aux entreprises européennes à forte intensité d’IA depuis son centre de données d’Amsterdam.

L’Uptime Institute a constaté que dans de nombreux cas, l’utilisation des néoclouds peut être plus rentable que les instances GPU proposées par les hyperscalers, signe peut-être qu’une croissance rapide se profile à l’horizon. En effet, McKinsey affirme que 70 % de la demande de centres de données concerne “l’infrastructure équipée pour accueillir des charges de travail d’IA avancées”.

Mais l’offre de ressources GPU n’est qu’une partie de l’histoire. Les fournisseurs de Neocloud devront également répondre aux attentes des utilisateurs en matière de vitesse et de latence tout en maintenant les services à un niveau de prix attractif. Pour cela, il faudra penser stratégiquement à la connectivité, identifier les emplacements appropriés et éventuellement développer des partenariats avec des fournisseurs de connectivité compétents en matière d’IA, plutôt que d’acheter de la capacité sur étagère.

4. Centres de données améliorés et micro-centres de données

Les néoclouds ne sont pas les seuls fournisseurs d’infrastructure à entrer dans l’ère de l’IA. Les centres de données traditionnels et les fournisseurs d’hébergement reconfigurent également leurs opérations pour répondre aux charges de travail de l’IA.

Lunar Digital, client de Zayo Europe, est une société de services de centres de données et de colocation qui investit dans de nouvelles capacités pour soutenir les cas d’utilisation intensive de l’IA, des diagnostics de santé à la détection des fraudes financières. Elle réorganise actuellement l’infrastructure de refroidissement de quatre centres de données de Manchester pour prendre en charge les déploiements de GPU à haute densité.

“Il permettra aux entreprises de libérer le potentiel de transformation de l’IA sans les contraintes d’alimentation et de refroidissement des environnements de colocation conventionnels”, nous a déclaré Robin Garbutt, PDG de l’entreprise.

Les entreprises qui exploitent une empreinte distribuée de micro-centres de données, quant à elles, peuvent être bien placées pour répondre aux exigences de latence des charges de travail d’IA en temps réel. Avec la bonne infrastructure en place pour connecter les centres de données périphériques entre eux et avec les centres de données centraux et les réseaux de transport, les opérateurs de micro-centres de données pourraient prendre l’avantage sur leurs concurrents plus centralisés

Par exemple, Pulsant, client de Zayo Europe, dispose de 12 centres de données périphériques stratégiquement situés au Royaume-Uni, notamment à Édimbourg, Manchester, Rotherham et Newcastle. Ces 12 centres sont interconnectés par le réseau à faible latence de Zayo Europe et ont accès à notre dorsale Internet mondiale de niveau 1, ce qui permet à Pulsant de répondre à des cas d’utilisation à faible latence en évitant les itinéraires de liaison encombrés passant par Londres.

Parlez à Zayo Europe de la connectivité pour les services d’IA

L’évolution de l’IA a déjà un impact profond sur la demande de connectivité “résiliente”. Ce phénomène ne fera que s’intensifier, car il faut davantage de capacité, des vitesses plus rapides et une latence plus faible pour répondre à la demande des clients.

Zayo Europe travaille déjà avec des entreprises dans toute l’Europe pour s’assurer qu’elles disposent de la bonne connectivité pour leurs cas d’utilisation actuels et futurs de l’IA. Des longueurs d’onde 400G aux réseaux de longueurs d’onde privés et à la fibre noire pour la connectivité longue distance et métropolitaine, nous avons une solution qui peut soutenir votre entreprise d’IA aujourd’hui et à l’avenir. Si vous souhaitez en savoir plus, n’hésitez pas à nous contacter.