Die Entwicklung der KI-bezogenen Dienste beginnt, die Nachfrage nach Hochgeschwindigkeits-Glasfasernetzen mit hoher Kapazität und niedriger Latenz neu zu gestalten. So sieht der Stand der Dinge aus unserer Sicht aus.

Für viele Menschen ist KI immer noch ein Novum. Sie müssen sich nur den jüngsten Meme-Wahn ansehen, den der Studio Ghibli-ähnliche Bildgenerator von OpenAI ausgelöst hat, um zu verstehen, dass die generative KI für den Massenmarkt noch in den Kinderschuhen steckt.

Aber hinter den Kulissen entwickelt sich KI weiter und reift – sowohl bei den Anwendungsfällen als auch bei den Diensten, die sie unterstützen. Bei vielen Anwendungsfällen geht es um große Datenmengen oder Reaktionsfähigkeit in Echtzeit, und das wirkt sich allmählich auf die Nachfrage nach Netzwerkgeschwindigkeit, Bandbreite und Latenzzeit aus.

In diesem Blog befassen wir uns mit vier aufkommenden KI-bezogenen Diensten und der Frage, wie belastbare Konnektivität den Erfolg in einer von verteilten, cloudbasierten Systemen beherrschten Welt untermauert.

Vier neue KI-Dienste und ihre Auswirkungen auf die Konnektivität

Die Entwicklung datenintensiver KI-Anwendungsfälle treibt die Einführung neuer Dienste durch etablierte Unternehmen und Start-ups gleichermaßen voran. Bei unserer Arbeit mit Unternehmen im Bereich der KI sehen wir vier neue Arten von Dienstleistungen entstehen.

1. Modell-Training in Echtzeit

Heutzutage werden große Sprachmodelle (LLMs) wie GPT-4, Llama und Claude vortrainiert, bevor sie Entwicklern und Benutzern zur Verfügung gestellt werden – GPT steht für generative pre-trained transformer. Das Sammeln von Trainingsdaten für diese Modelle ist nicht zeitkritisch, und das Training wird offline durchgeführt.

Jetzt gehen einige Dienste zu einem Echtzeit-Ansatz über, bei dem kontinuierlich Daten gesammelt und zum Training des Modells verwendet werden. Echtzeit-Training kann in Sektoren eingesetzt werden, in denen sich die Informationen für die Entscheidungsfindung schnell ändern, z.B. in der Verteidigung, im Gesundheitswesen oder im Bankwesen.

Die Auswirkungen auf die Bandbreitenanforderungen sind hier potenziell kolossal, je nach Umfang und Art der gesammelten Daten sowie dem Standort der Daten und des zu trainierenden Modells. Ein strategischer Ansatz für die Konnektivität und vertrauenswürdige, flexible Konnektivitätspartner werden unerlässlich sein.

2. Inferenz-Cluster

Inferenzcluster stehen für den Einsatz einer bestimmten vortrainierten LLM für einen bestimmten Zweck. Ein Beispiel könnte der Chatbot eines Einzelhändlers sein, der GPT4 als Modell verwendet. Inferenz ist die Arbeit, die von der vortrainierten LLM geleistet wird, um relevante Antworten auf die Anfrage eines Kunden zu generieren.

Die zunehmende Verwendung von LLMs macht es aus Sicht des Datentransports teuer, die gesamte Inferenzarbeit am selben physischen Ort wie das Modell durchzuführen – zum Beispiel, wenn das Modell in den USA gehostet wird, die Benutzer aber in Europa sind.

Es wird auch erwartet, dass die Inferenzmaschine in Echtzeit auf die Nutzer reagiert. Und je nach Branche können die Regulierungsbehörden auch verlangen, dass die Nutzerdaten in Europa bleiben, was die Verwendung eines in den USA gehosteten Modells ausschließt.

Eine Lösung ist der Aufbau von Inferenz-Clustern: lokalisierte Einsätze des Modells, bei denen die Benutzerdaten lokal bleiben, die Daten über kürzere Entfernungen transportiert werden müssen und die aufgrund der geringeren Latenzzeit schneller reagieren.

Unternehmen, die geografisch verteilte Inferenzcluster einsetzen, benötigen eine garantierte Verbindung mit hoher Bandbreite und geringer Latenz zu, von und zwischen den einzelnen Clustern, um die Modelle synchron und auf dem neuesten Stand zu halten, um eine wachsende Benutzerbasis zu bewältigen und um unvorhersehbare Nutzungsspitzen zu bewältigen.

3. Neoclouds

Die wachsende Nachfrage nach Inferenz-Clustern und anderen verteilten LLM-Einsätzen treibt das Entstehen einer neuen Art von Infrastrukturanbietern voran. Da LLMs leistungsstarke Grafikprozessoren benötigen, um ausgeführt werden zu können, beobachten wir den Aufstieg von “Neocloud”-Unternehmen, die Grafikprozessor-Ressourcen als Service (GPUaaS) anbieten.

Neoclouds arbeiten nach einem ähnlichen verbrauchsbasierten Modell wie die Hyperscaler und sind speziell auf die Verarbeitung von KI-Workloads ausgerichtet – vom Modelltraining bis hin zu Inferenzen und prädiktiven Analysen. Digital Ocean beispielsweise bietet KI-intensiven europäischen Unternehmen Bare-Metal-GPUs in seinem Rechenzentrum in Amsterdam an.

Das Uptime Institute hat herausgefunden, dass die Nutzung von Neoclouds in vielen Fällen kostengünstiger sein kann als die von Hyperscalern angebotenen GPU-Instanzen – vielleicht ein Zeichen dafür, dass ein schnelles Wachstum bevorsteht. In der Tat sagt McKinsey, dass 70 % der Nachfrage nach Rechenzentren für “Infrastrukturen, die für fortschrittliche KI-Workloads ausgestattet sind”, besteht.

Aber das Angebot von GPU-Ressourcen ist nur ein Teil der Geschichte. Neocloud-Anbieter müssen auch die Erwartungen der Nutzer in Bezug auf Geschwindigkeit und Latenzzeit erfüllen und gleichzeitig ihre Dienste zu einem attraktiven Preis anbieten. Das bedeutet, dass man strategisch über die Konnektivität nachdenken muss, indem man geeignete Standorte identifiziert und möglicherweise Partnerschaften mit KI-versierten Konnektivitätsanbietern entwickelt, anstatt Kapazitäten von der Stange zu kaufen.

4. Erweiterte und Mikro-Rechenzentren

Neoclouds sind nicht die einzigen Infrastrukturanbieter, die sich auf das KI-Zeitalter einstellen. Auch traditionelle Rechenzentren und Hosting-Anbieter stellen ihren Betrieb um, um KI-Arbeitslasten zu bewältigen.

Lunar Digital, ein Kunde von Zayo Europe, ist ein Unternehmen für Rechenzentren und Colocation-Services, das in neue Fähigkeiten investiert, um KI-intensive Anwendungsfälle zu unterstützen – von der Gesundheitsdiagnostik bis zur Erkennung von Finanzbetrug. Das Unternehmen überarbeitet derzeit die Kühlungsinfrastruktur in vier Rechenzentren in Manchester, um den Einsatz von GPUs mit hoher Dichte zu unterstützen.

“Sie wird es Unternehmen ermöglichen, das transformative Potenzial von KI ohne die Energie- und Kühlungsbeschränkungen herkömmlicher Colocation-Umgebungen zu erschließen”, sagte uns CEO Robin Garbutt.

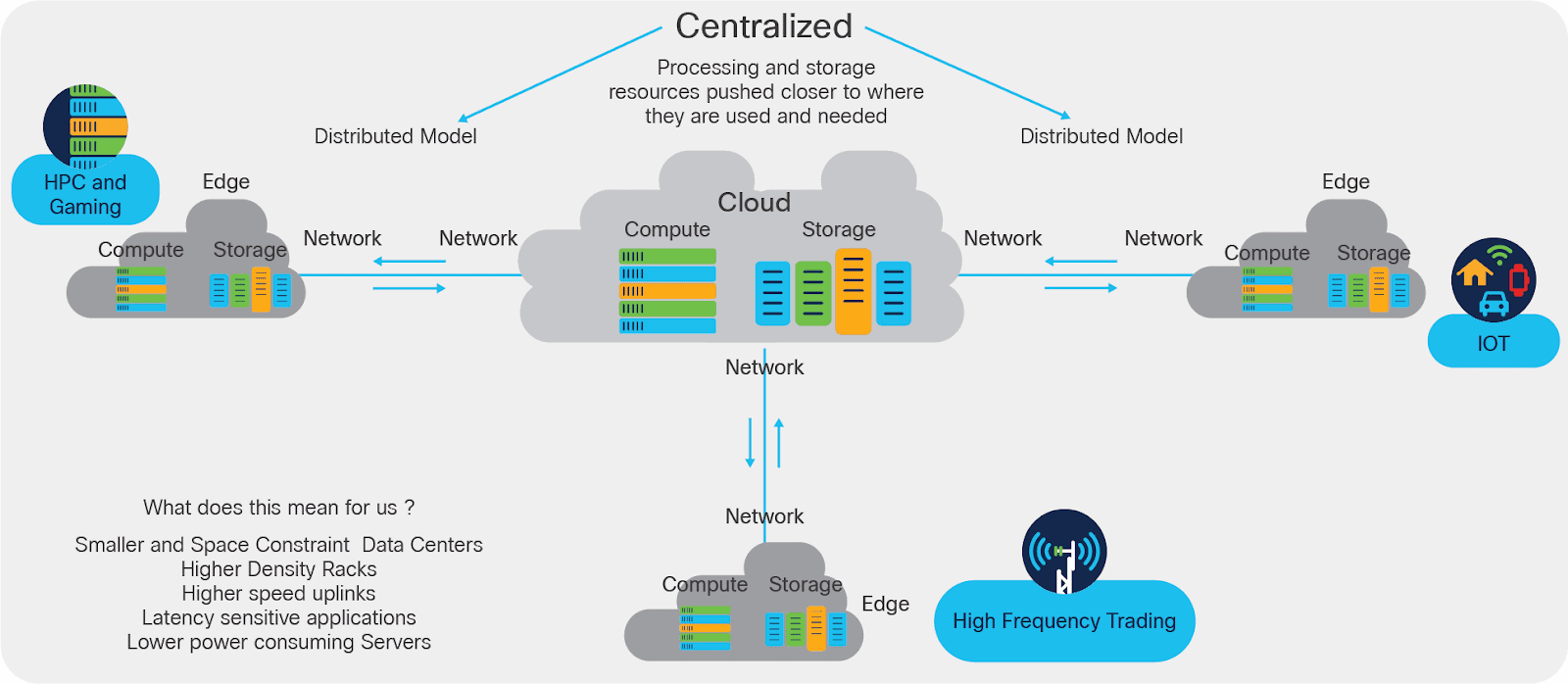

Unternehmen, die ein verteiltes Netz von Mikro-Rechenzentren betreiben, sind unterdessen möglicherweise gut aufgestellt, um die Latenzanforderungen von Echtzeit-KI-Workloads zu erfüllen. Mit der richtigen Infrastruktur für die Verbindung von Edge-Rechenzentren untereinander und mit Kernrechenzentren und Transportnetzwerken können Betreiber von Mikrorechenzentren einen Vorteil gegenüber zentraleren Wettbewerbern erlangen.

Pulsant, ein Kunde von Zayo Europe, verfügt beispielsweise über 12 Edge-Rechenzentren, die strategisch über Großbritannien verteilt sind, darunter Edinburgh, Manchester, Rotherham und Newcastle. Alle 12 sind über das Zayo Europe-Netzwerk mit niedriger Latenz und Zugang zu unserem globalen Tier-1-Internet-Backbone miteinander verbunden. Das bedeutet, dass Pulsant Anwendungsfälle mit niedriger Latenz bedienen kann, indem es überlastete Backhaul-Routen über London vermeidet.

Sprechen Sie mit Zayo Europe über Konnektivität für KI-Dienste

Die Entwicklung der künstlichen Intelligenz hat bereits jetzt tiefgreifende Auswirkungen auf die Nachfrage nach “belastbarer” Konnektivität. Dies wird sich noch verstärken, da mehr Kapazität, höhere Geschwindigkeiten und geringere Latenzzeiten erforderlich sind, um die Nachfrage der Kunden zu befriedigen.

Zayo Europe arbeitet bereits mit Unternehmen in ganz Europa zusammen, um sicherzustellen, dass sie über die richtige Konnektivität für ihre aktuellen und zukünftigen KI-Anwendungsfälle verfügen. Von 400G-Wellenlängen über private Wellenlängennetzwerke bis hin zu Dark Fibre für Langstrecken- und Metrokonnektivität – wir haben eine Lösung, die Ihr KI-Geschäft heute und in Zukunft unterstützen kann. Wenn Sie mehr wissen möchten, nehmen Sie bitte Kontakt mit uns auf.